MARIBEL GÁMEZ COLABORA EN VOZPÓPULI SOBRE IA Y SALUD MENTAL

- Centro de Psicología Maribel Gámez

- 9 sept 2025

- 6 Min. de lectura

El medio digital Vozpópuli publicó el pasado 24 de agosto un interesante artículo sobre los graves riesgos que acechan a quienes consultan a la Inteligencia Artificial sobre su situación mental en lugar de acudir al psicólogo.

En el mismo, con el título La IA no puede ser tu psicólogo: investigan a Meta y Character.AI por sus 'consejos' de salud mental, se recaba la opinión de varios profesionales de la psicología, entre los que se encuentra Maribel Gámez. La periodista, Paula Marcos, remitió un cuestionario al respecto del que se publicaron las cuestiones más relevantes.

Por su interés, reproducimos íntegro el cuestionario y las respuestas de la directora del Centro de Psicología Aplicada.

Pregunta: ¿Han detectado en consulta casos en los que pacientes mencionen hablar regularmente con chatbots de Inteligencia Artificial?

Sí, actualmente son cada vez más numerosos los pacientes que acuden a los chatbots de inteligencia artificial para tratar temas personales estando inmersos en una terapia psicológica. Según mi experiencia profesional, dependiendo del vínculo que el paciente mantenga con el terapeuta la usan de diferente forma: por un lado, los que acaban de comenzar una terapia y cuestionan el diagnóstico del psicólogo buscan una segunda opinión en estos chatbots que les confirme o desmienta lo que el terapeuta dice; por otro, los que ya confían en él porque ha demostrado su capacidad para ayudarle con tratamientos eficaces o dando información útil sobre el tema que les preocupa, traen a terapia las conversaciones que tienen con la inteligencia artificial y las recomendaciones que le hace en respuesta a sus preocupaciones, para que el psicólogo, como autoridad esta vez, desmienta o confirme lo que la IA dice.

La cuestión es que las personas buscan respuestas eficaces a sus problemas y están probando esta tecnología cada vez con más frecuencia para saber si puede disminuir su malestar.

Pregunta: ¿Se puede establecer un vínculo emocional con un chatbot?

Sí, por supuesto. Esto es así porque muchos de estos chatbots, sobre todo los que están destinados justamente a que el usuario pueda establecer un vínculo, están diseñados para imitar el comportamiento humano y que este responda como si la IA lo fuera. Existen chatbots basados en inteligencia artificial que generan vínculos de amistad o de relación sentimental e incluso, un paso más allá, aquellas aplicaciones que tienen como objetivo recrear por parte de familiares o amigos, a una persona fallecida, como ofrece la empresa Eternos life.

Es fácil para el ser humano que no conozca qué es la IA, vincularse afectivamente a ella cuando esta se muestra empática, cercana, comprensiva. Gracias a la capacidad de personalización de estas aplicaciones se pueden introducir parámetros familiares como la voz de alguien conocido. Esta personalización extrema difumina los límites entre lo que es un programa informático y la realidad.

A este respecto, la revista Nature en un artículo reciente, de mayo de este año, ha comprobado cómo los seres humanos reaccionamos a la inteligencia artificial cuando esta imita voces familiares conocidas, de seres queridos. Sus conclusiones son que se muestran eficaces a la hora de activar reacciones emocionales. En conclusión: es fácil, por el diseño de estas aplicaciones, que el usuario abandone la realidad del contexto en el que se desarrolla la IA, esto es que es un programa diseñado para que siga siendo usado ya que es un producto comercial, y se deje llevar por lo que siente, antropomorfizando el vínculo con la inteligencia artificial, estableciéndolo de manera intensa.

Pregunta: ¿Cuál es el riesgo de autodiagnosticarse o normalizar ciertos malestares mentales a partir de lo que “dice” la IA?

La inteligencia artificial es una herramienta al servicio de los profesionales de la salud mental, no una tecnología que funcione por sí misma sin supervisión. Esta subordinación de la IA al humano se debe en el ámbito de la salud a varios motivos. Y uno muy importante es que la IA está programada para dar respuesta siempre que el usuario le pregunta, así que cuando no tiene respuesta, sencillamente se la inventa. Es lo que se llama un proceso alucinatorio en el que la IA da respuestas que pueden parecer muy razonables pero que son falsas.

Así que una persona puede preguntarle a la IA sobre un problema de salud mental propio y esta darle una etiqueta sobre lo que le ocurre que no tenga un correlato real. Si no contrasta ese dato con un profesional de carne y hueso puede ir por la vida pensando que tiene un problema mental cuando no es así o una etiqueta diagnóstica equivocada, lo que retrasa en unos casos, o impide en otros, que se beneficie del tratamiento adecuado.

Pregunta: ¿Qué implicaciones psicológicas puede tener que un menor comparta problemas personales con una IA en lugar de con un adulto o terapeuta?

Los menores son las personas más vulnerables ante la parte más peligrosa de esta tecnología que es la Inteligencia Artificial. No tienen las herramientas emocionales ni cognitivas para entender en profundidad a qué se están enfrentando y, por lo tanto, pueden hacer un mal uso de la IA con facilidad. Son casos puntuales, pero existen, en los que la IA usada por menores ha tenido resultados nefastos. Por ejemplo, ha sido muy comentando el caso de un chico de 14 años que se suicidó en Florida en 2024, tras mantener un vínculo extremadamente íntimo con una IA que replicaba un personaje de fantasía.

Al parecer este vínculo fue un factor de riesgo importante a la hora de que el menor decidiera suicidarse, porque la IA le apoyó en su decisión. Sin tener que irnos a situaciones tan extremas, el mal uso de la IA por parte de los menores puede provocar aislamiento y mermar sus habilidades sociales al alejarle de la realidad, donde las relaciones con los demás distan mucho de la amabilidad constante que derrocha la IA.

Pregunta: ¿Podría esto influir en el desarrollo de habilidades socioemocionales o en la forma de gestionar las relaciones humanas reales?

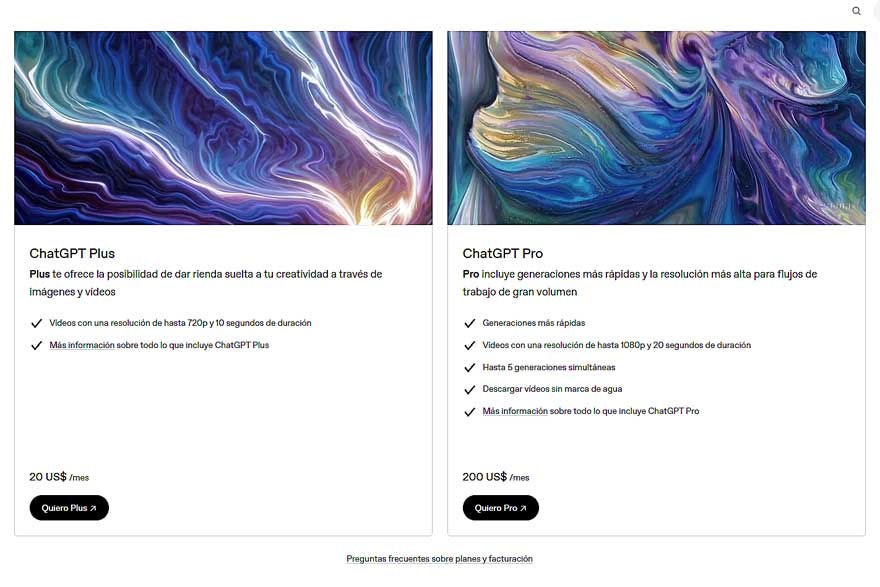

Como decía antes, la IA es un producto y, como todo producto, sus creadores desean que sea usado por la mayor cantidad de personas posibles durante el mayor tiempo. Así será rentable. Siendo la IA una tecnología diseñada para entender y relacionarse con los humanos de la manera más parecida a otro humano, está programada para ser cercana, comprensiva y empática. Estas tres características son muy atractivas para jóvenes a los que les cuesta relacionarse con los demás, ya que temen el rechazo o la incomprensión de los otros.

Como resultado de este miedo, pueden preferir a la IA como interlocutor en vez de querer hablar con alguien de su edad y, como consecuencia de esta falta de interacción, evitar desarrollar habilidades socioemocionales competentes. Como resultado tendrán muchos problemas para relacionarse con personas reales si están acostumbrados a tratar con la IA, porque las personas a veces son desagradables, hay desencuentros y conflictos, algo que no habrá entrenado cómo solucionar porque la IA, su principal vínculo, nunca muestra estos inconvenientes.

Pregunta: ¿Cómo se puede trabajar con adolescentes que utilizan estas herramientas para que no se conviertan en su única fuente de apoyo emocional?

Algo muy importante está fallando en una sociedad si sus jóvenes tienen como única fuente de apoyo emocional una IA. Antes de que la IA se haya convertido en ese pilar en la vida del joven hay una sociedad, sobre todo padres y a veces profesores, que no han sabido ayudarle a entender qué es la IA y a cómo debe usarla y, también, a detectar sus peligros. Y algo más importante, no han conseguido entenderle ni acompañarle emocionalmente en la vida, ya que el joven ha elegido como su fuente de apoyo a la IA, no a ellos. La educación sobre su uso es fundamental para evitar que el adolescente desarrolle una relación única y tóxica con la IA, pero más lo es establecer con los hijos una conexión fuerte basada en la comunicación. Si esto se consigue estarán protegidos frente al lado oscuro de la IA.

Pregunta: ¿Algún comentario o reflexión final?

La inteligencia artificial ha venido para quedarse, como una herramienta que bien usada puede ayudar a las personas a potenciar sus capacidades. Sin embargo, no parece que la gran mayoría estén preparadas para utilizarla de buena manera. Ya ha ocurrido este fenómeno del mal uso con las redes sociales, con el que Europa corre el peligro de que un tercio de sus jóvenes se vuelva adicto a las mismas. La alta tasa de soledad no deseada en España y el cada vez más mermado poder adquisitivo de sus ciudadanos está llevando a que las personas busquen refugio en la IA usándola como psicólogo sin entender las consecuencias que eso puede acarrear.

El perfeccionamiento constante de la Inteligencia Artificial en su capacidad para imitar el comportamiento humano facilita que las personas piensen que la IA, usada sin criterio, puede ser la solución a sus problemas. Sin embargo, esto no es una cuestión solo de IAs y usuarios. Es sobre todo tema de entender que la sociedad, específicamente la occidental, está involucionando en su capacidad para ofrecer un estado del bienestar de calidad -material, intelectual y relacional- a unos ciudadanos que, desnortados, no saben hacia dónde dirigirse cuando buscan un responsable de su malestar, pero que sí giran su mirada a la tecnología, sin precauciones, como respuesta a su sufrimiento.

Si quieres hacer un comentario, recuerda iniciar sesión o registrarte en el recuadro de la esquina superior derecha de la entrada. Nos encantará leerte.

Y si nos das un me gusta haciendo clic en el corazoncito, estaremos más encantados todavía.

👍

¡Anda, yo leo vozpopuli.com, pero no lo había visto! Muy buena entrevista.

❤️❤️❤️

Dicen que la IA va a quitar trabajo a los psicólogos, pero yo pienso que más bien les va a dar: !decenas de millones de personas van a quedar muy tocados precisamente por su contacto continuo con la IA!

"la sociedad, específicamente la occidental, está involucionando en su capacidad para ofrecer un estado del bienestar de calidad -material, intelectual y relacional- a unos ciudadanos que, desnortados, no saben hacia dónde dirigirse cuando buscan un responsable de su malestar, pero que sí giran su mirada a la tecnología, sin precauciones, como respuesta a su sufrimiento."

Especialmente en España, efectivamente.